Non vitae sed machinae discimus?

In dieser Folge widmen wir uns einer Frage, die alle in der Lehre Tätigen interessieren könnte und die sich ob des KI-Hypes aufdrängt: Welche Rolle kann Künstliche Intelligenz in der ärztlichen Ausbildung spielen, welche Rolle soll sie spielen, welche nicht? Und: Kann Software artifizieller Intelligenz vielleicht sogar Aufgaben humaner Dozierender substituieren? Anlass für unsere Überlegungen ist ein einfach verblindeter randomisiert-kontrollierter Vergleich, den ein Autorenteam um Emma Lavigne et al. mit knapp 250 Medizinstudierenden in Montpellier und Nîmes unternommen hat.

Das neue EvidenzUpdate

Ab sofort hat der Podcast ein neues Zuhause auf www.evidenzupdate.de, die langjährige Zusammenarbeit mit der Ärzte Zeitung haben wir beendet und gehen neue Wege.

Plus für alle zu dieser Episode: Zusammenfassung der Studie und Take-Home-Messages für den klinischen (lehrenden) Alltag.

Plus für alle Unterstützer zu dieser Episode: Wie immer das vollständige Transkript.

Schreiben Sie uns: podcast@evidenzupdate.de

KI im ärztlichen Alltag: Zwischen Tool und Verdacht

Für Martin Scherer sind KI-Tools eine „reflexive Parallelspur“, die zunehmend in den Lehr- und Arbeitsalltag eindringen: Man liest Hausarbeiten, Artikel, Bewerbungen – und fragt sich unweigerlich: „Wie viel ist da selbst geschrieben?“ Der „große KI-Verdacht“ sei ständiger Begleiter. „KI ist omnipräsent. Die Frage ist nur: Wo ist der Mensch noch drin?“

Die Studie: KI-Training verbessert OSCE-Ergebnisse

Anlass unseres Gesprächs ist eine neue französische randomisiert-kontrollierte Studie (RCT), deren Ergebnisse im NEJM AI veröffentlicht wurden. Die Autorengruppe untersucht, ob ein KI-Trainingssystem die Prüfungsergebnisse im OSCE (Objective Structured Clinical Examination) verbessern kann. Die einfache Antwort lautet: Ja, kann es.

Die Interventionsgruppe nutzte 2,5 Monate lang vor der Prüfung die GPT-4-basierte Plattform DocSimulator, auf der KI-gestützt Anamnesen und Kasuistiken mit Feedback trainiert werden konnten. Keine Multiple Choice-Fragen, sondern freier Text, echte Interaktion mit einem Chatbot, Punktzahl und Benchmarking inklusive.

Die Kontrollgruppe hatte das Standardtraining – sprich: klinische Rotationen und Übungssessions. Geprüft wurden beide Gruppen am Ende gleich – und verblindet. Das heißt, die Prüfer waren verblindet und wussten nicht, welche Studis ein AI-Training hatten, welche nicht.

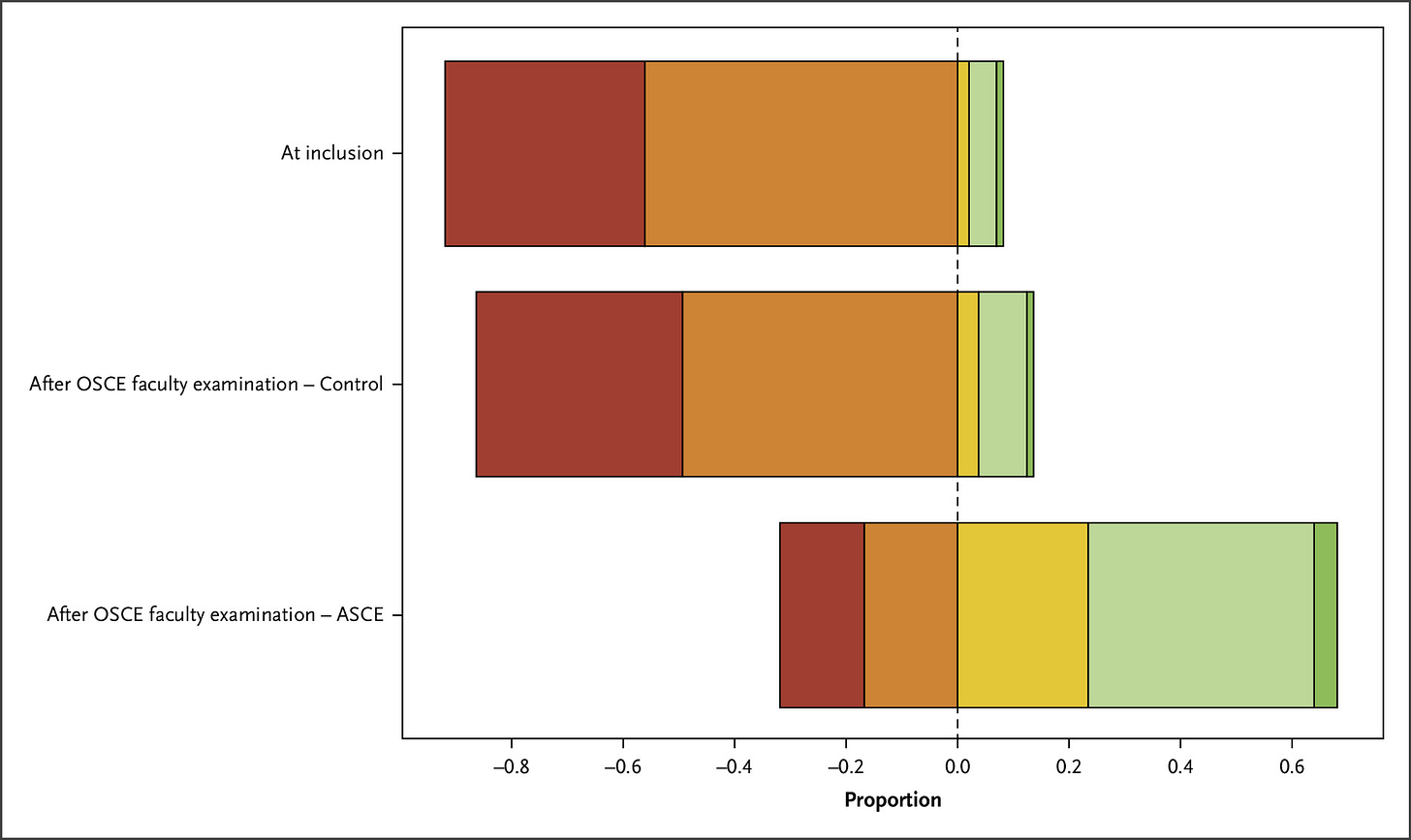

Ergebnis: Die KI-Gruppe schnitt in 4 Stationen des OSCE-Parcours signifikant besser ab (Median 11,4 vs. 10,7 Punkte von jeweils maximal 20 Punkten). Und die Prüflinge waren weniger gestresst.

Mehr emotionale Sicherheit, weniger Lampenfieber

Neben dem Prüfungserfolg profitierten die mit dem KI-Tool vorbereiteten Studis emotional: Sie fühlten sich besser vorbereitet, weniger gestresst und zeigten weniger Prüfungsabsentismus. Scherer interpretiert das so: „Es gibt Sicherheit in einer unsicheren Situation. Wie beim Probekonzert vor dem großen Auftritt.“

Methodik: RCT, aber nicht perfekt

Trotz randomisiertem Studiendesign kann man einiges kritisch zu hinterfragen:

Nur zwei Fakultäten in Frankreich → eingeschränkte Übertragbarkeit

Kein Zugang zu körperlicher Untersuchung oder nonverbaler Kommunikation

Teils uneinheitliche Baseline-Merkmale (z. B. mehr Lernende mit Vorkenntnissen in der Kontrollgruppe)

Keine Adjustierung der Gruppenunterschiede

Kein echter Langzeit-Endpunkt wie etwa: Werden daraus bessere Ärzt:innen?

Fazit: Hypothesengenerierend, nicht paradigmenschiebend.

Chancen & Risiken: Didaktische KI vs. Deskilling

Scherer sieht das Potenzial des KI-Trainings als ergänzend, aber warnt auch vor Übernutzung: „KI darf Werkzeug sein – nicht Erzieher.“

Die Gefahr: Deskilling, also der schleichende Verlust ärztlicher Urteilskraft durch zu viel Algorithmus-Komfort. Auch Rao et al. heben im begleitenden Editorial zum Artikel diesen Punkt hervor: „This expertise cannot be downloaded.“ Und KI, so der Tenor, kann zwar Feedback geben, aber nicht Haltung, Empathie oder Ambiguitätstoleranz vermitteln.

Hausärztliche Perspektive: KI bleibt (noch) außen vor

Skepsis äußert Scherer mit Blick auf die hausärztliche Medizin, deren Essenz schwer digitalisierbar sei:

Ungeplante Kontakte

Vage Symptome

Wiederkehr und Zeitverlauf

Beziehung, Zuhören, Unsicherheit

Das alles, so Scherer sei zwar „schwer simulierbar, aber umso wichtiger.“ Nößler: „Ist KI die größte Gefahr für die Hausarztmedizin?“ Scherer: „Eher nicht. Aber ich bin gespannt, wie weit die Entwickler kommen.“

„Wir müssen Lernen neu denken – aber KI erden“, wünscht sich Scherer. Das ärztliche Lernen sei mehr als Informationsverarbeitung, es sei Haltungsbildung. Und genau das – Haltung, Urteilskraft, Empathie – lässt sich nicht einfach trainieren wie ein Multiple-Choice-Test.

Die Studie in Kürze

Design

RCT, einfach verblindet, zwei Zentren in Frankreich (Montpellier, Nîmes)

(P)247 Studierende im frühen klinischen Studienabschnitt (4. Jahr)(I)Interventionsgruppe erhielt 2,5 Monate Zugang zur Plattform DocSimulator(C)Kontrollgruppe erhielt Standardtraining ohne Zugang zur Plattform(O)Primärer Endpunkt: OSCE-Leistung (Median-Scores)Sekundäre Endpunkte: emotionale Bereitschaft, Stresslevel, subjektiver Realismus, Zufriedenheit

Ergebnisse

OSCE-Score: Median 11,4 (KI-Gruppe) vs. 10,7 (Kontrollgruppe); p = 0,02

Emotionale Bereitschaft: signifikant höher in der KI-Gruppe (Median 3 vs. 2)

Stressniveau: signifikant niedriger in der KI-Gruppe (Median 4 vs. 5)

74 % fühlten sich wie im echten Patientenkontakt, 67 % wie von Lehrenden bewertet

100 % der KI-Gruppe würden die Plattform weiterempfehlen

Einschränkungen

Nur zwei Fakultäten → eingeschränkte Generalisierbarkeit

Keine Erfassung nonverbaler/interpersoneller Skills

Kein echter „klinischer Endpunkt“

Teilnahmequote geht so, teils Baseline-Ungleichheiten

Fazit

ASCE-Training kann (in Südfrankreich) die OSCE-Leistung von Studierenden der Humanmedizin verbessern und emotionale Vorbereitung, die Tools sind grundsätzlich skalierbar und können knappe humane Ausbilderressourcen schonen. Aber ein Ersatz für die reale ärztliche Interaktion sind sie nicht.

Take-Home-Messages

Was wir mitnehmen können:

🧪 Studienfazit: KI-gestütztes OSCE-Training kann die Prüfungsleistung im medizinischen Staatsexamen verbessern und den Prüfungsstress reduzieren – zumindest kurzfristig und in diesem französischen RCT.

🤖 Didaktisches Potenzial: KI kann eventuell Lücken füllen, wo Lehrende oder Simulationspatienten fehlen.

🧍♂️ Aber: Empathie, Haltung und ärztliche Intuition kann KI (noch?) nicht vermitteln. Und der RCT von Lavigne et al. kann uns nichts über die Langzeiteffekte des KI-Einsatzes sagen, bspw. über die Qualität der ärztlichen Ausbildung, die Qualität der Examina, die Einflüsse auf lange Zeit.

🔄 Risiko für Deskilling: Mit dem zunehmenden Einsatz von KI in der ärztlichen Ausbildung und Prüfungsvorbereitung, könnte das Training klinischen Gespürs leiden.

🧭 Rolle der Lehre: KI darf Assistenz sein, aber nicht Erzieherin. Ärztliches Lernen bleibt ein menschlicher Reifungsprozess.

⚖️ Empfehlung: Lehrende sollten bewusste Leitplanken setzen, wann und wofür KI-Tools sinnvoll eingesetzt werden. Und gerade die sprechende, kontemplative, unsichere Medizin ist schwer simulierbar.

Offene Fragen

Was wir nicht wissen und wozu Lavigne et al. uns nichts mitteilen können:

🔄 (Langzeit-)Effekte auf ärztliche Urteilskraft:

Ob ein kurzfristiger oder langfristige Einsatz von KI zur Lernunterstützung und Prüfungsvorbereitung im Medizinstudium Auswirkungen auf die ärztliche Arbeit hat, das hat die Studiengruppe gar nicht untersucht.🧍♂️ Fehlende Beobachtung ärztlicher Entwicklung über Zeit:

Die Studie endet mit der Examensprüfung. Ob die KI-Einsatz im späteren ärztlichen Berufsalltag Auswirkungen hat, etwas dass die Kolleg:innen sicherer diagnostizieren, patientenzentrierter kommunizieren oder anders mit Ungewissheiten umgehen, all das bleibt offen.🧰 Mögliches „Deskilling“ durch zu viel Automation:

Wer sich zu früh und zu stark auf automatisiertes Feedback verlässt, trainiert womöglich zu wenig eigene klinische Urteilskraft. Es besteht die Gefahr, dass ärztliches Denken abflacht, weil es algorithmisch vorstrukturiert wird. Aber auch dazu wissen wir aus der vorliegenden Arbeit nichts.🤔 Unklare langfristige Risiken durch KI:

Immerhin gibt es Hinweise aus einer kleinen – noch nicht peer-reviewten – Studie von Kosmyna et al., dass der KI-Einsatz beim Schreiben eines Aufsatzes zu einer verringerten neuronalen Verschaltung führt.

Literatur

Nagendran M, Festor P, Komorowski M, et al. Eye tracking insights into physician behaviour with safe and unsafe explainable AI recommendations. npj Digit Med 2024;7(1):202. doi:10.1038/s41746-024-01200-x

Lavigne E, Lopez A, Frandon J, et al. AI-Standardized Clinical Examination Training on OSCE Performance. NEJM AI Published Online First: 14 July 2025. doi:10.1056/aioa2500066

Rao AS, Artino AR. AI-Driven OSCE Preparation in Medical Education: Promise, Pitfalls, and Practical Implications. NEJM AI Published Online First: 14 July 2025. doi:10.1056/aie2500527

Deutscher Ethikrat. Stellungnahme: Mensch und Maschine - Herausforderungen durch Künstliche Intelligenz. 2023. www.ethikrat.org

Kosmyna N, Hauptmann E, Yuan YT, et al. Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task. arXiv Published Online First: 10 June 2025. doi:10.48550/arxiv.2506.08872